SGI® Altix® ICE

Vlastnosti systému

SGI® Altix® ICE je další generací blade platformy, která zákazníkům poskytuje výborný poměr cena/výkon a přináší očekávané vlastnosti clusterových systémů, ale s jednoduchou ovladatelností, škálovatelností a snadným použitím typicky spojené s SMP systémy.

Zatímco tradiční clustery složené z malých uzlů poskytují hodnotu a flexibilitu pro malé až střední systémy, v případě systémů rozsáhlých naráží na několik kritických problémů: poměr cena/výkon, účinnost zdrojů datového centra, spolehlivost a ovladatelnost. Na druhé straně SMP systémy, známé svojí ovladatelností, rozšiřitelností a funkcionalitou jsou určené zpracovávat požadavky v náročných HPC prostředích, ale často za cenu, že se mnoho zákazníků clusterů zdráhá takové systémy pořídit.

SGI Altix ICE nabízí zákazníkům další možnost a poskytuje nejlepší řešení pro běh scale-out aplikací bez jakýchkoli kompromisů v oblasti správy, nákladů a poměru cena/výkon.

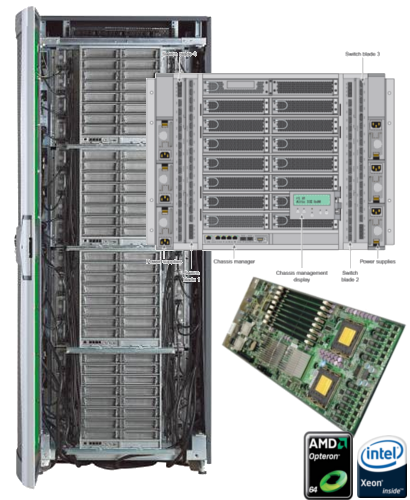

Výpočetní uzly

SGI® Altix® ICE je scale-out distribuovaným paměťovým systémem postaveným na architektuře x86_64. Díky dvou socketovým Intel® Xeon® a AMD Opteron™. uzlům disponuje hustotou 128 socketů na jeden kabinet (10U). Propojení jednotlivých výpočetních uzlů je zabezpečeno pomocí single-plane nebo dual-plane QDR InfiniBand interkonektům a tím je možné škálovat systém od 32 do 65 536 uzlů.

Úložný prostor

Výpočetní uzly je možné v případě potřeby osadit diskovými jednotkami. Nasazení bez lokálního úložiště na výpočetních uzlech snižuje potřebné místo, spotřebu a vyzářené teplo. Nativní úložný prostor je pro Altix ICE poskytován například díky SGI InfiniteStorage Server 3500, který je vyúžíván pro přístup jak na souborové (NFS over IB), tak i blokové úrovni (iSER).

Instalace

Tovární integrace a předkonfigurace (power up & go) dramaticky snižuje čas potřebný pro instalaci celého systému u koncového zákazníka na hodiny/dny z týdnů či měsíců. Pro celý systém je k dispozici možnost využít chlazení vodou nebo pouze vzduchem. Součástí systému je i předinstalovaný a předem zoptimalizovaný kompletní softwarový stack, obsahující software pro optimalizaci výkonu (SGI® ProPack™), system management (SGI® Tempo), management pracovní zátěže (Altair® PBS Professional™), MPI (Intel MPI Runtime nebo SGI MPT) a IB a subnet management (SGI InfiniBand Fabric Subnet Management - postavený na OFED a OpenSM).

Výkon systému

Nejrychlejší počítačový systém s distribuovanou pamětí

Rychlost

- Nejrychlejší počítačový systém s distribuovanou pamětí (SPECmpiL_2007)

- Nejrychlejší systém pro výpočet dynamiky kapalin (ANSYS FLUENT 12.0)

Rozšiřitelnost

- QDR InfiniBand topologie umožňující propojení až 65 536 výpočetních uzlů

Otevřený design

- Využití operačního systému Linux

- Intel® Xeon® nebo AMD Opteron

- Standardní QDR InfiniBand interkonekt

Vertikální market

- CFD a CAE

- Energetika a geologie

- Obrana a zpravodajské služby (výzvědné služby)

- Biologie, biochemie, výzkum a vývoj, univerzity

Topologie InfiniBand interkonektu

Škálovatelnost systému dovoluje díky InfiniBand interkonektu propojit až 65 536 výpočetních uzlů v 1 024 racích. Podporovány jsou následující InfiniBand topologie:

All to All

- Topologie omezena počtem portů na InfiniBand přepínačích

Fat Tree

- Požadavky na InfiniBand přepínače rostou nelineárně s rozsáhlostí systému

- Obtížná instalace kabeláže vedoucí k páteřním přepínačům

Mesh or Torus(2, 3 nebo více rozměrné)

- Topologie zavádí problémy s latencí a počtem skoků se zvětšující se velikostí

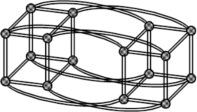

Hypercube/Enhanced Hypercube [viz obrázek]

- Topologie je rozšiřitelná až k velmi rozsáhlým systémům

- Požadavky na InfiniBand přepínače rostou úměrně s velikostí systému

- Latence a počet skoků zůstávají nízké

- Rozměrové aspekty Hypercube dovolují mít nezávislé cesty pro místní i globální provoz

Podporovaný software

Aplikační software

| Target Solution Description | Key Applications | Customer Needs/Drivers | SGI Altix ICE Advantage (Key points to emphasize) |

| Render Mgmt | Mental Images/Mental Ray, PFX/Qube | Expedite builds and Accelerate production with highest quality | Dense High Performance processors, smaller foot print and lower energy consumption |

| Image Processing | Color grading & Image compositing | Large shared and centralized compute resource which can be parsed according to workloads | High-speed IB interconnect |

| CFD | Fluent, StarCD, CFD++, PowerFlow | Ease of IT mgmt, scalability and compute density | Low energy consumption, high compute density and integrated IB interconnect |

| CRASH | LS-DYNA, PAMCRASH, RADIOSS | Low power usage and space savings | |

| Scientific workflow solution | BLAST, InforSense, TeraNode, Mitrionics, etc. | Hybrid computing environment for complex scientific workflow processes. Large shared centralized computing resource needs across departments. | Minimized single points of failure (power supplies, fans, disks, IB interconnect) increases the likelihood that long running MPI jobs will run to completion. |

| Reservoir Simulation | Schlumberger Eclipse, Landmark Nexus | Easy to manage scalable cluster systems that can run a mix of highthroughput and highperformance applications. | IB interconnect for storage access can deliver greater than 200MB/Sec |

| Seismic Processing | Pre- and post-stack depth migration including Landmark ProMax Paradigm GeoDepth | High availability for each node and interconnect to ensure that applications run to completion. Easy to manage high throughput clusters High I/O performance (greater than 200MB/Sec for 8 cores) High density, low power and low cost | Dense packaging, enhanced energy efficiency and optional water cooled doors enable large cluster deployment in small spaces. |

Systémový software

- SUSE® Linux Enterprise Server

- Red Hat® Enterprise Linux

Technická specifikace

Compute Blades |

||||||||||||||||||

Processors Memory, IO and Storage |

|

|||||||||||||||||

Blade Enclosures |

||||||||||||||||||

Interconnect Power and Cooling |

|

|||||||||||||||||

Storage |

||||||||||||||||||

| High-performance IPoIB solutions |

|

|||||||||||||||||

Racks |

||||||||||||||||||

| 42U (30"W x 40"D) Rack |

|

|||||||||||||||||

System Management |

||||||||||||||||||

| Hierarchical Management Framework Controllers |

|

|||||||||||||||||

| Service Node Options |

Service nodes can be optionally configured with:

|

|||||||||||||||||

System Software |

||||||||||||||||||

| Operating Systems |

|

|||||||||||||||||

| Cluster Solution Stack |

|

|||||||||||||||||

Software Development |

||||||||||||||||||

| Programming Languages and Debuggers |

|

|||||||||||||||||

| Libraries |

|

|||||||||||||||||

Cílové zaměření

- Velké společnosti

- Univerzity

- Organizace zaměřené na vývoj

- Banky a finanční instituce

- Telekomunikační operátoři

- Massive high performance computing

- Business intelligence

V případě, že hledáte platformu pro specifická řešení, pokračujte na:

- Massive High Performance Computing (Altix ICE, Altix UV, CloudRack C2)

- Vědecké výpočty - velké organizace a univerzity (Altix UV, Prism XL), pracovní skupiny (Octane III)

- Náročné grafické aplikace (Octane III)

- Vývojová centra a týmy (Octane III, CloudRack X2, Origin 400)

- Mobilní datová centra (ICE Cube)

- Cloud computing (Rackable HalfDepth Servers, Altix UV, Origin 400)